Membrane

28.10.2019

Membrane mit Interface im Kunstverein Tiergarten Galerie Nord

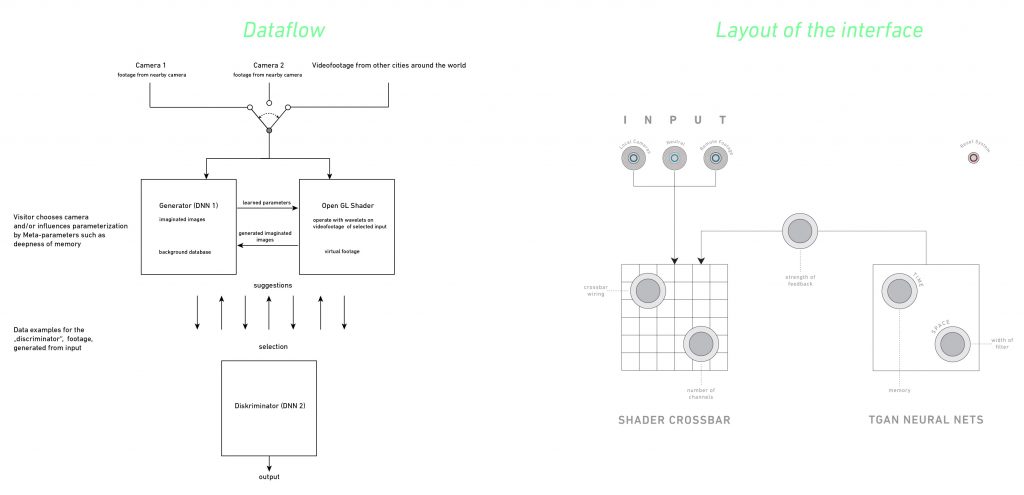

Membrane ist eine Kunstinstallation, die als Hauptwerk einer gleichnamigen Ausstellung im Kunstverein Tiergarten in Berlin Anfang 2019 produziert wurde. Sie baut auf einer Reihe von generativen Videoinstallationen mit Echtzeit-Videoeingabe auf. Membrane erlaubt es dem Betrachter, direkt mit der Generierung des Bildes durch ein neuronales Netzwerk, hier den sogenannten TGAN-Algorithmus, zu interagieren. Eine Schnittstelle ermöglicht es, die „Vorstellungskraft“ des Computers zu erleben und den Besucher je nach Neugier und persönlichen Vorlieben zu führen.

Die Bilder von Membrane stammen von einer statischen Videokamera, die eine Straßenszene in Berlin beobachtet. Eine zweite Kamera ist im Ausstellungsraum positioniert und kann nach Belieben bewegt werden. Auf zwei Bildschirmen werden beide Szenen in Echtzeit gezeigt.

In meinen früheren künstlerischen Experimenten haben wir in diesem In meinen früheren künstlerischen Experimenten haben wir in diesem Kontext jedes Pixel eines Videodatenstroms als eine operative Einheit betrachtet. Ein Pixel lernt aus Farbfragmenten während der Laufzeit des Programms und liefert eine Farbe, die als Summe aller Farben während der Laufzeit der Kamera betrachtet werden kann. Diese einfache Speichermethode schafft etwas grundlegend Neues: eine Aufzeichnung von Bewegungsmustern an einem bestimmten Ort.

Auf technischer Ebene kontrolliert Membrane nicht nur Pixel oder klar umrissene Details eines Bildes, sondern Bild-„Merkmale“, die erlernt, gespeichert und wieder zusammengesetzt werden. Um beim Beispiel der Farbe zu bleiben: Wir wählen Merkmale aus, aber ihre Eigenschaften werden an einen Algorithmus delegiert. TGANs (Temporal Generative Adversarial Nets) realisieren „unbeaufsichtigtes Lernen“ durch den gegenläufigen Rückkopplungseffekt zweier Teilnetze: Ein Generator erzeugt kurze Bildsequenzen und ein Diskriminator bewertet das künstlich erzeugte Filmmaterial. Der Algorithmus wurde speziell entwickelt, um Repräsentationen von unkategorisierten Videodaten zu erzeugen und – mit Hilfe dieser – neue Bildsequenzen zu produzieren. (Temporal Generative Adversarial Nets).

Sound: Teresa Carrasco, Bern

Die Arbeit wurde erstellt mit freundlicher Hilfe des Kreativfonds Bauhaus Universität Weimar und des HEK Basel

https://vimeo.com/349417754

Hier mein Vortrag auf der Konferenz Re-Imagining AI

https://vimeo.com/showcase/6375722/video/366513412